Поговорить с "цифровой копией" умершего человека? Возможно ли и этично ли?

24.05.2016Стартап Luka выпустил чат-бота на основе переписки погибшего в автокатастрофе человека - Романа Мазуренко, бывшего арт-директора небезызвестной в Москве "Стрелки".

Диалоговая модель построена на базе алгоритмов Deep Learning и нейронной сети, которой "скормили" сообщения из переписки, фотографии, статьи, воспоминания (включая воспоминания о Романе его друзей). Теоретически модель может отвечать так, как отвечал бы когда-то погибший человек.

Возникает сразу несколько вопросов. И первый из них - этично ли помещать модель личности умершего человека в "робота", в данном случае, в "чат-бота". Кто должен давать согласие на создание и использование такого рода моделей? Вопросов такого рода можно задать еще немало. Тема активно обсуждается в мире, поскольку уже несколько компаний заявили о планах создания таких роботов.

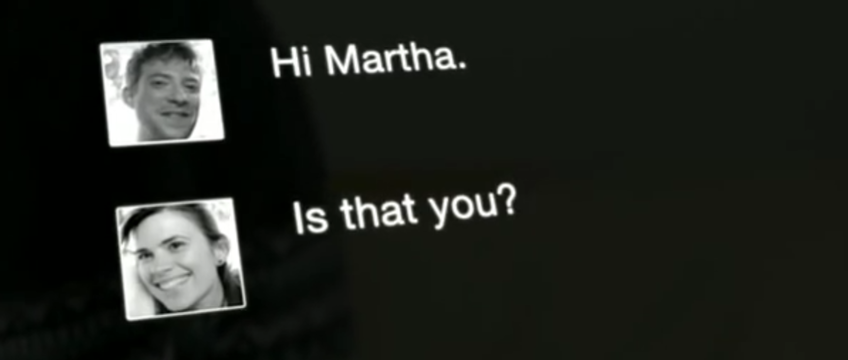

И второе. Высокие технологии сегодня действительно неплохи. Но настолько ли они зрелы, чтобы проводить подобные действия? Не получится ли, что присущие современному уровню технологий ограничения превратят продукт в какую-то насмешку над памятью человека - вспомните недавние сообщения о судьбе одного из микрософтовских чат-ботов? Может быть не стоит торопиться с реализацией таких сценариев, чтобы не повторился известный сюжет из одной из серий Черного зеркала под названием "Скоро вернусь"?

С другой стороны, концепция чат-бота "обученного" на базе переписки и воспоминаний близких, мало чем отличается от существующих цифровых средств сохранения воспоминаний, при помощи которых люди вспоминают умерших сейчас - фотографии, видеозаписи. Называя вещи своими именами, речь идет лишь о повышении степени интерактивности в “общении” с воспоминаниями.

А как вы считаете? Этичны ли такие действия, как создание цифровой копии недавно умершего человека? Не приведет ли появление таких способов "общения" с информацией об ушедших близких к серьезным психологическим последствиям для их близких?

+ +

+ +

Источник: